官博链接:

https://machinelearning.apple.com/research/introducing-apple-foundation-models

虽然Siri确实可以直接调用GPT接口,但这只是仅仅是Apple Intelligence可调用的外部模型之一。

根据博客介绍,Apple Intelligence背后的基础模型是苹果自研的一个约30亿参数的端侧语言模型(Apple On-Device)和一个通过私有云计算并在 Apple 芯片服务器上运行的更大的基于服务器的语言模型(Apple Server),这些模型都针对苹果用户的日常行为进行了微调训练。

妥妥地是为自己正名了。毕竟大模型如火如荼的一年半时间里苹果直接“销声匿迹”,这次终于闷声干了件大事,肯定不能被隔壁偷家了。

Apple Intelligence由多个强大的LLM组成,针对用户体验进行了设计和微调,能够执行编写和优化文本摘要、确定通知优先级、为与家人和朋友的对话创建有趣的图像,以及简化跨应用的操作等任务。

苹果官网目前详细介绍了其中两个模型:其中一个参数量为3B,可以直接在手机等终端设备上运行;另一个是更大的语言模型,虽然没有明确参数量,但其性能可以与GPT-4对标。该模型可通过私有云计算获得,并在Apple的服务器上运行。

接下来,我们一起来看看这两个模型的技术实现是如何完成的。

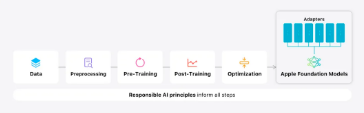

模型的训练主要分为以上5步,我们一个一个看。

基础模型是在Apple的AXLearn框架上训练的,这是Apple在2023年发布的一个开源项目。AXLearn构建在JAX和XLA之上,能够在各种训练硬件和云平台上高效且可扩展地训练模型,包括TPU以及云端和本地的GPU。此外,还结合使用了数据并行、张量并行、序列并行和完全分片数据并行(FSDP)来在数据、模型和序列长度等多个维度上扩展训练。

训练数据均来源于授权数据,包括为增强特定功能而选择的数据,以及通过爬虫AppleBot收集的公开数据,并删除了隐私敏感和带有侮辱歧视字眼的数据。

Apple在官网上提到,他们使用了两个原创的算法用于后训练,显著提升了模型的指令执行效果。

(1) 使用教师委员会(teacher committee)的拒绝采样微调算法(rejection sampling fine-tuning algorithm)

(2) 使用镜像下降策略优化(mirror descent policy optimization)和留一优势估计(eave-one-out advantage estimator)的来自人类反馈的强化学习 (RLHF) 算法

(1) 分组查询注意力机制(Grouped Query Attention, GQA):无论是设备端还是服务器端的模型,都使用了分组查询注意力机制。通过共享的输入和输出词汇嵌入表,以减少内存需求和推理成本。设备端模型的词汇量为49K,而服务器模型的词汇量为100K,包括额外的语言和技术词汇。

(2) 低比特化量化(Low-bit):在设备端推理中,采用了低比特化技术,这是实现必要的内存、功耗和性能要求的关键优化技术。为了保持模型质量,开发了一个新的框架,使用LoRA适配器结合了混合的2-bit和4-bit配置策略——平均每个权重为3.5bit,以达到与未压缩模型相同的准确性。

(3) Talaria:Talaria是一个交互式模型延迟和功耗分析工具,可以更好地指导每个操作的比特率选择。模型还使用了激活量化和嵌入量化,并开发了一种方法,在神经引擎上实现高效的Key-Value(KV)缓存更新。

通过这一系列优化,在iPhone 15 Pro上可以实现每个提示token约0.6毫秒的首个token延迟,以及每秒生成30个token的速度。这种性能是在不使用token推测技术的情况下实现的,而使用该技术后,token生成速度将进一步提高。

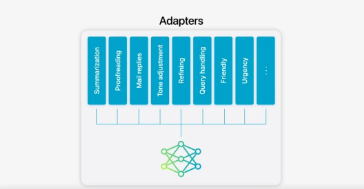

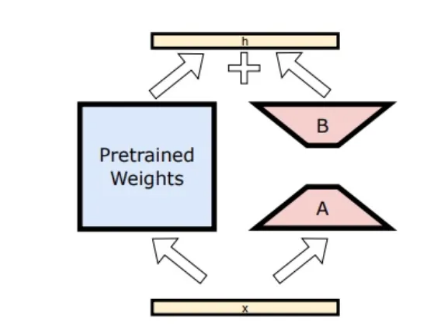

模型微调的方法是Adapter微调,即把小型神经网络模块插入预训练模型的各层,只训练这些小网络而不改变预训练模型的参数。具体来说,对注意力矩阵、注意力投影矩阵以及点状前馈网络中的全连接层进行适配,从而调整Transformer架构中解码层的合适部分。

通过仅微调适配器层,基准预训练模型的原始参数保持不变,从而保留了模型的通用知识,同时将适配器层调整为支持特定任务。模型使用了16位表示适配器参数,对于约30亿参数的设备端模型,rank 16 适配器的参数通常只需要几十兆字节。这些适配器模型可以动态加载,暂时缓存于内存中,并进行交换——使基础模型能够在执行任务时动态专门化,同时高效管理内存并保证操作系统的响应速度。

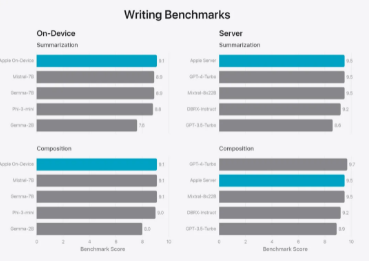

说了这么多,那么这两个模型的性能表现到底如何呢?下面给出了6个维度的评估。3B的小模型就称为Apple On-Device,服务器上运行的大模型就称为Apple Server。

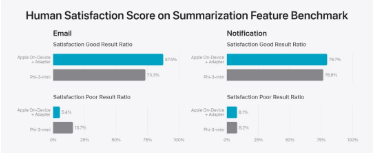

首先是评估模型的摘要生成能力,根据评分者在五个维度上的得分,摘要被分为“好”、“中”、“差”。如果所有维度都很好(越高越好),则结果被归类为“好”。如果任何一个维度很差(越低越好),则结果被归类为“差”。

可以看到Apple On-Device的摘要生成能力强于同类模型Phi-3-mini。

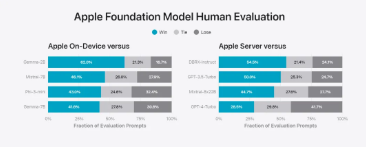

此项评估全面考察模型能力,问题包括头脑风暴、分类、封闭式问答、编码、提取、数学推理、开放式问答、重写、安全、总结和写作等主要类别,生成的结果也由人类评估。

可以看到3B小模型 Apple On-Device性能强于Gemma-7B,而大模型Apple Server性能强于GPT-3.5-Turbo,略逊于GPT-4-Turbo。

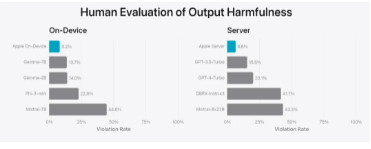

此评估考察了针对有害内容、敏感话题和事实的违规回应比例(越低越好)。

可以看到,Apple On-Device和Apple Server比现有的模型都安全的多,这也符合苹果公司一向谨慎行事的风格。

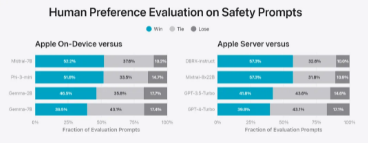

模型仅仅安全还不够,这项评估考察了输入的内容是合法内容时,人类评估者更喜欢哪个模型生成的内容。

可以看到,Apple On-Device和Apple Server生成的话更受人类喜欢。

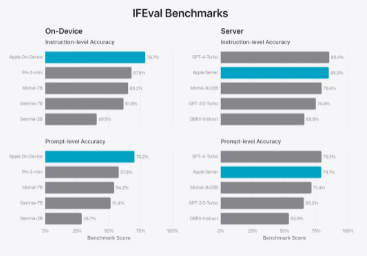

这项评估测试了模型遵循人类指令的能力,可以看到两个模型的能力都较为领先。

最后一项评估是写作能力评估,可以看到两个模型的能力也丝毫不落后。

值得留意的是,苹果的这些模型在预训练之后,又利用苹果用户的设备行为日志做了微调训练&adapter训练,这也难怪它在系统级的任务上表现这么惊艳。

由于OpenAI根本没有这些系统级的用户数据,所以GPT系列模型再进化也很难去胜任操作系统级别的任务,从这个角度来看,如果OpenAI始终只是苹果系统里的一个APP,那注定未来堪忧啊。

电话:13476186895

邮箱:59248235@qq.com

网址:http://www.whlunyu.com

地址:武汉市江岸区中一路小微企业创业园A栋709